قد لا يكون لديك علم بأنّك تملك قدرة السيطرة على محركات البحث.

هل يبدو الأمر غريباً! لكن حقيقة، يمكنك التلاعب بمن يقوم بالزحف إلى موقعك (Crawl) وفهرسته (Index)، وصولاً إلى الصفحات الفردية (Individual pages). للتحكم في ذلك، ستحتاج إلى استخدام ملف (robots.txt).

تَحكّم محركات البحث على المواقع بشكل صارم وقاسٍ، لذلك من الضروري ترك انطباع رائع. باستخدام ملف (robots.txt) بشكل صحيح، يمكنك تحسين معدل الزحف، مما قد يؤثر على جهود تحسين محركات البحث لديك.

لنتعلم سوية في هذا المقال، كيف تصنع واحداً؟ كيف تستخدمه؟ ما الأشياء التي يجب عليك تجنبها؟

ما هو ملف robots txt؟

هو ملف نصّي بسيط، يوجد داخل دليل الجذر “Root directory” لموقع الويب الخاص بك. يقوم بإعلام الروبوتات (robots or Spiders) التي يتم إرسالها بواسطة محركات البحث بالصفحات التي يجب الزحف إليها، والتي يجب التغاضي عنها.

لكن لا بدّ من ذكر أنّه ليس من الضروري أن يلتزم كل روبوت بالقواعد التي تكتبها في ملف robots.txt الخاص بك.

Google مثلاً؛ لن يستمع إلى أي توجيهات تضعها في الملف حول تكرار الزحف.

أهمية ملف robots.txt للمواقع الإلكترونية؟

يفيد ملف robot.txt في الحالات التي تريد المزيد من التحكم في ما يتم الزحف إليه، إليك بعض الفوائد لامتلاك الملف:

- المساعدة في إدارة التحميل الزائد للخادم Server overloads.

- يمكنك الاحتفاظ بالمحتوى المكرر بعيداً عن(SERPs)، يمكنك منع إهدار الزحف عن طريق الروبوتات، التي تزور الصفحات، التي لا تريد أن تقوم بها، مثل الصفحات التي تحتوي على المحتوى المكرر.

- يساعدك في الحفاظ على خصوصية مجلدات، أو نطاقات فرعية معينة.

- يساعد في تحديد موقع ملف Sitemap الخاص بك؛ وهي نقطة مهمة جداً، حيث تسمح لبرامج الزحف بمعرفة مكان ملف Sitemap الخاص بك، حتى يتمكنوا من مسحه ضوئياً.

كيف يعمل ملف robots.txt

يُخبر ملف robots.txt محركات البحث بكيفية الزحف إلى الصفحات المُستضافة على موقع الويب الخاص بك. المكونان الرئيسيان لملف robots.txt الخاص بك هما:

- User-agent: يحدد محرك البحث أو روبوت الويب web bot، الذي تنطبق عليه القاعدة. إن أردت تضمين كل محركات البحث، يمكنك استخدام علامة النجمة (*) مع User-agent.

- Disallow: ينصح محرك البحث بعدم الزحف إلى ملف ما، أو صفحة، أو دليل، وفهرسته.

robots.txt وUser-Agents

يتكون ملف robots.txt من كتل من سطور التوجيهات. سيبدأ كل توجيه بوكيل مستخدم User-Agents، ثمّ يتمّ وضع قواعد وكيل المستخدم تحته.

عندما يهبط محرك بحث معين على موقع الويب الخاص بك، فإنه سيبحث عن وكيل المستخدم الذي ينطبق عليه، ويقرأ الكتلة التي تشير إليه. هناك العديد من التوجيهات التي يمكنك استخدامها في ملفك، منها (User-Agent).

يَسمح لك أمر وكيل المستخدم (user-agent command) باستهداف بعض الروبوتات، أو العناكب لتوجيهها. على سبيل المثال؛ إذا كنت تريد فقط استهداف Bing أو Google، فهذا هو التوجيه الذي تستخدمه.

على الرغم من وجود المئات من وكلاء المستخدم، إليك أمثلة لأشهر خيارات وكيل المستخدم:

- User-agent: Googlebot

- User-agent: Googlebot-Image

- User-agent: Googlebot-Mobile

- User-agent: Googlebot-News

- User-agent: Bingbot

- User-agent: Baiduspider

- User-agent: msnbot

- User-agent: yandex

من المهم معرفة أنّ وكلاء المستخدم حساسون لحالة الأحرف، لذا عليك التأكد من إدخالهم بشكل صحيح.

كيف تجد ملف robots.txt الخاص بك؟

- يقع ملف robots.txt دائماً في المجال الجذر root domain لموقع الويب.

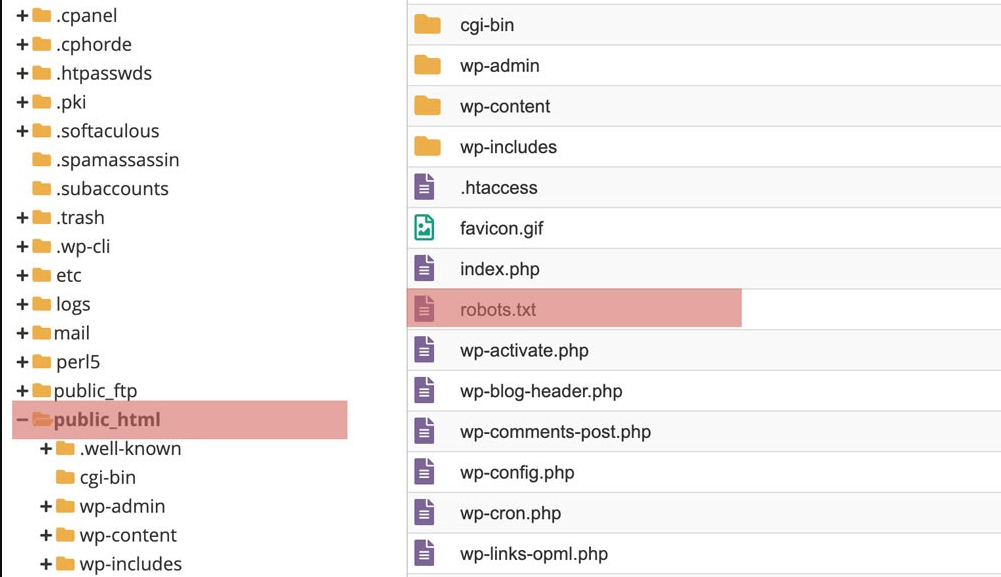

- في معظم مواقع الويب، يجب أن تكون قادراً على الوصول إلى الملف الفعلي، حتى تتمكن من تحريره في (FTP)، أو عن طريق الوصول إلى (File Manager) في لوحة تحكم المضيفين لديك (Hosts CPanel).

- في بعض منصات CMS، يمكنك العثور على الملف في منطقتك الإدارية مباشرةً Administrative area.

- إذا كنت تستخدم WordPress، فيمكن الوصول إلى ملف robots.txt في المجلد public_html في موقع الويب الخاص بك.

إنشاء ملف robots.txt خطوة بخطوة

كيف تكتب الأوامر في ملف robots.txt

يتضمن ملف (robots.txt) توجيهات(directives) مثل (meta robots)، بالإضافة إلى إرشادات على مستوى الصفحة، أو الدليل الفرعي، أو على مستوى الموقع، لكيفية تعامل محركات البحث مع الروابط (مثل متابعة “follow” أو عدم متابعة “nofollow”).

- تظهر كل مجموعة من توجيهات وكيل المستخدم كمجموعة منفصلة، مفصولة بفاصل أسطر.

- في حال وجود توجيهات متعددة لوكيل المستخدم، تنطبق كل قاعدة عدم السماح، أو السماح إلا على وكيل (وكلاء) المستخدم المحددين، في تلك المجموعة المعينة المفصولة بأسطر. إذا كان الملف يحتوي على قاعدة تنطبق على أكثر من وكيل مستخدم واحد، فلن ينتبه الزاحف (ويتبع التوجيهات الواردة في) سوى مجموعة التعليمات الأكثر تحديداً.

إضافات لبناء robots.txt

إذا لم يكن لديك ملف robots.txt موجود على الخادم الخاص بك، فيمكنك بسهولة إضافة ملف باتّباع الخطوات التالية:

- اِفتح محرر النصوص المفضل لديك “Notepad, TextEdit, Microsoft Word” لبدء مستند جديد.

- أضف التوجيهات التي ترغب في تضمينها في المستند.

- احفظ الملف باسم “robots.txt”

- اختبر ملفك كما سنوضح في الفقرة اللاحقة.

- قم بتحميل ملف (txt) الخاص بك على الخادم الخاص بك باستخدام (FTP)، أو في لوحة التحكم (CPanel) الخاصة بك. ستعتمد طريقة تحميله على نوع موقع الويب لديك. في WordPress، يمكنك استخدام مكونات إضافية مثل(Yoast)، و (All In One SEO)، و (Rank Math)، لإنشاء ملفك وتحريره.

- يمكنك أيضاً استخدام أداة منشئ ملف robots.txt لمساعدتك.

نصائح لبناء ملف robots.txt

إليك بعض النصائح حول استخدام الملف بشكل صحيح وإلّا تقع في كارثة تحسين محركات البحث:

- يجب وضع ملف robots.txt في دليل المستوى الأعلى لموقع الويب، لكي يتم العثور عليها.

- لا تحظر المحتوى الجيد.

من المهم عدم حظر أي محتوى جيد ترغب في تقديمه للدعاية، عن طريق ملف robots.txt، أو علامة noindex. يجب عليك فحص صفحاتك بدقة بحثاً عن علامات noindex، وقواعد عدم السماح disallow rules. - الإفراط في استخدام تأخير الزحف Crawl-Delay

يجب تجنّب استخدامه كثيراً، لأنك تحدّ من الصفحات التي يتم الزحف إليها بواسطة برامج الروبوت. قد يكون هذا مثالياً لبعض مواقع الويب، ولكن إذا كان لديك موقع ويب ضخم، فقد تمنع التصنيفات الجيدة وحركة المرور القوية لموقعك.

- حساسية الأحرف Case Sensitivity

ملف robots.txt حسّاس لحالة الأحرف، لذلك عليك أن تتذكر إنشاء ملف robots بالطريقة الصحيحة. يجب استدعاء ملف robots باسم “robots.txt”، وكل ذلك [أحرف صغيرة. وإلا فلن يعمل!

- استخدام ملف robots.txt لمنع فهرسة المحتوى

يُعدّ عدم السماح بإحدى الصفحات Disallowing a page، هو أفضل طريقة لمحاولة منع الروبوتات من الزحف إليها مباشرةً. لكنها لن تعمل في الظروف التالية:- إذا تم ربط الصفحة من مصدر خارجي، ستستمر الروبوتات في التَّدفق عبر الصفحة وفهرستها.

- ستستمر برامج التتبع غير الشرعية في الزحف إلى المحتوى وفهرسته.

- استخدام ملف Robots.txt لحماية المحتوى الخاص

بعض المحتويات الخاصة مثل ملفات PDF، أو صفحات الشكر قابلة للفهرسة، حتى إذا وجهت الروبوتات بعيداً عنها.

تتمثل إحدى أفضل الطرق للتوافق مع توجيه عدم السماح في وضع كل المحتوى الخاص بك خلف تسجيل دخول.

بالطبع، هذا يعني أنه يضيف خطوة أخرى للزائرين، لكن المحتوى الخاص بك سيظل آمناً. - استخدام ملف Robots.txt لإخفاء المحتوى الضّار المكرر

أحياناً يكون المحتوى المكرر شرّاً لابدّ منه. ومع ذلك، فإن Google ومحركات البحث الأخرى أذكياء بما يكفي لمعرفة متى تحاول إخفاء شيء ما. في الواقع، قد يؤدي القيام بذلك في الواقع إلى جذب المزيد من الانتباه إليه.

أمثلة على ملف robots.txt

ملف robots.txt للوردبريس

بالنسبة لمعظم مواقع WordPress، فإن المثال التالي هو الأفضل:

ملف robots.txt للـ Woo-commerce.

بشكل افتراضي، يقوم WordPress تلقائياً بإنشاء ملف robots.txt افتراضي لموقعك. لذا، فمن المفترض أن يحتوي موقعك بالفعل على ملف robots.txt الافتراضي حتى لو لم تضفه. يمكنك اختبار ما إذا كانت هذه هي الحالة من خلال إلحاق “/robots.txt” بنهاية اسم المجال الخاص بك.

نظراً لأن هذا الملف افتراضي، فلا يمكنك تعديله. إذا كنت تريد تعديل ملف robots.txt، فسيلزمك إنشاء ملف فعلي على خادمك يمكنك معالجته حسب الحاجة. ولمعرفة طريقة التعديل يمكنك زيارة الرابط.

ملف robots.txt لل Open Cart

- إنّ إعدادات ملف robots.txt ستغطي نطاقاً واحداً فقط في كل مرة، لذلك بالنسبة للمتاجر المتعددة، يتعين عليك إنشاء ملفات robots.txt منفصلة لكل متجر.

- العديد من محركات البحث تبحث عن ملف robots.txt مباشرة تحت جذر متجرك وليس ضمن دليل.

- بمجرد إنشاء ملف robots.txt، من المفترض أن يكون موجوداً في جذر موقعك. على سبيل المثال، إذا كان مجال متجرك هو www.mystore.com، فيجب عليك وضع ملف robots.txt ضمن جذر المجال حيث يكون لديك أيضاً دليل التطبيق. لذلك يجلس ويتم الوصول إليه مثل www.mystore.com/robots.txt.

ملف robots.txt للـ Magento

لتهيئة ملف robotx.txt في Magento 2:

- انتقل إلى: المحتوى> التصميم> التكوين، Content > Design > Configuration.

- اختر المتجر الذي تريد تكوين ملف robots.txt الافتراضي له.

- ابحث عن قسم روبوتات محرك البحث.

- اختر الروبوتات الافتراضية التي تريد تمكينها على موقع الويب الخاص بك.

- في قسم تحرير التعليمات المخصصة لقسم ملف robot.txt، أدخل التعليمات المخصصة التي تريد أن يقوم محرك البحث بتحليل موقع الويب الخاص بك وفقاً لها. انقر فوق الزر “إعادة تعيين الإعدادات الافتراضية” في حالة رغبتك في حذف كافة الإرشادات المخصصة، والعودة إلى الإرشادات الافتراضية.

- لا تنس حفظ الإعدادات Configuration.

ملف robots.txt للـ laravel

إذا كنت تريد أن يعمل ملف robots.txt في Laravel، فيجب وضعه في المجلد العام. يمكنك معرفة كيفية تنصيبه واستخدامه من خلال زيارة الرابط.

كيفية اختبار ملف robots.txt قبل إرساله

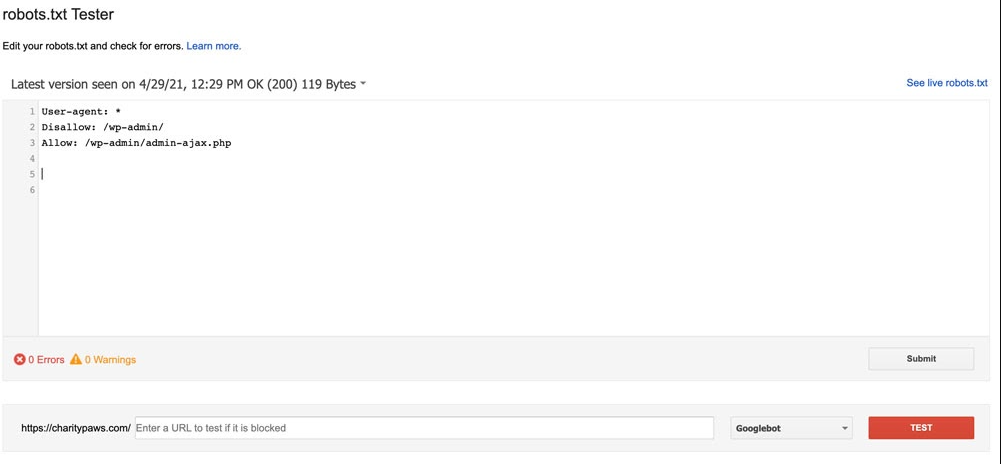

قبل بدء تشغيل رمز ملف robots.txt الذي أنشأته، ستحتاج إلى تشغيله من خلال أحد المختبرين للتأكد من صحته. سيساعد هذا في منع المشكلات المتعلقة بالتوجيهات غير الصحيحة التي ربما تمت إضافتها.

لا تتوفر أداة اختبار ملف robots.txt إلا في الإصدار القديم من Google Search Console. إذا لم يكن موقع الويب الخاص بك متصلاً بـ Google Search Console ، فستحتاج إلى القيام بذلك أولاً.

قم بزيارة صفحة دعم Google ثم انقر فوق الزر “فتح اختبار ملف robots.txt”. حدد الخاصية التي ترغب في اختبارها ثم سيتم نقلك إلى شاشة، مثل الشاشة أدناه.

اختبار رمز ملف robots.txt الجديد الخاص بك، ما عليك سوى حذف ما هو موجود حالياً في المربع واستبداله بالرمز الجديد الخاص بك والنقر فوق “اختبار”. إذا كانت الاستجابة لاختبارك “مسموحاً بها”، فهذا يعني أن الكود الخاص بك صالح، ويمكنك مراجعة ملفك الفعلي باستخدام الكود الجديد.

أحدث التعليقات